La inteligencia artificial (IA) ya no es una tecnología emergente: es una realidad consolidada en múltiples sectores. Sin embargo, su creciente adopción ha puesto sobre la mesa una serie de desafíos éticos, técnicos y organizacionales que requieren una respuesta estructurada. Según un análisis reciente de Gartner, para que la IA sea segura y verdaderamente efectiva, es indispensable ir más allá del rendimiento algorítmico y adoptar un enfoque integral de gobernanza, riesgo y seguridad.

1. La necesidad urgente de una IA confiable

Gartner advierte que muchas organizaciones están implementando modelos de IA sin controles adecuados. Esto puede generar resultados sesgados, decisiones erróneas, pérdida de reputación e incluso riesgos legales. Para mitigar esto, la IA debe diseñarse desde su concepción con principios de fiabilidad, equidad, transparencia y responsabilidad.

2. Gestión de Riesgos de IA: Nace el concepto de AI TRiSM

El marco denominado AI TRiSM (AI Trust, Risk and Security Management) es clave. Este enfoque proporciona directrices para administrar:

- Transparencia: entender cómo y por qué la IA toma decisiones.

- Equidad: evitar sesgos algorítmicos que perjudiquen a ciertos grupos.

- Privacidad: proteger los datos personales usados en el entrenamiento.

- Robustez: asegurar que el modelo funcione bien en diversos contextos y que resista ataques adversarios.

- Regulación: cumplir con normativas como la AI Act en Europa o las guías de la NIST en EE. UU.

Gartner predice que, para 2026, las organizaciones que apliquen prácticas de AI TRiSM tendrán un 80% más de éxito en sus proyectos de IA.

3. Involucrar múltiples actores en el desarrollo de la IA

La IA no es un asunto exclusivo del área de TI. Es necesario un enfoque multidisciplinario que involucre a:

- Equipos de TI y ciencia de datos

- Legales y cumplimiento normativo

- Recursos humanos (especialmente para el desarrollo de talento ético)

- Alta dirección

Cada uno de estos actores aporta una visión crítica para construir modelos útiles, éticos y sostenibles.

4. Modelos preentrenados: ¿Útiles pero arriesgados?

Los modelos fundacionales o foundation models, como los usados por ChatGPT, Gemini o Claude, son poderosos, pero también opacos. Las empresas que los utilicen deben establecer mecanismos para auditar su funcionamiento, limitar su uso a escenarios apropiados y mitigar posibles alucinaciones o sesgos.

No se trata solo de usar IA, sino de usarla bien.

5. Implicaciones legales y éticas: el nuevo campo de batalla

Los marcos legales internacionales están avanzando. Normas como:

- Reglamento de IA de la Unión Europea

- Guías de la NIST en EE.UU.

- Iniciativas de IA Responsable (Responsible AI)

…ya están obligando a las empresas a rendir cuentas. No contar con un programa de ética de IA será, en poco tiempo, tan inaceptable como no tener políticas de ciberseguridad.

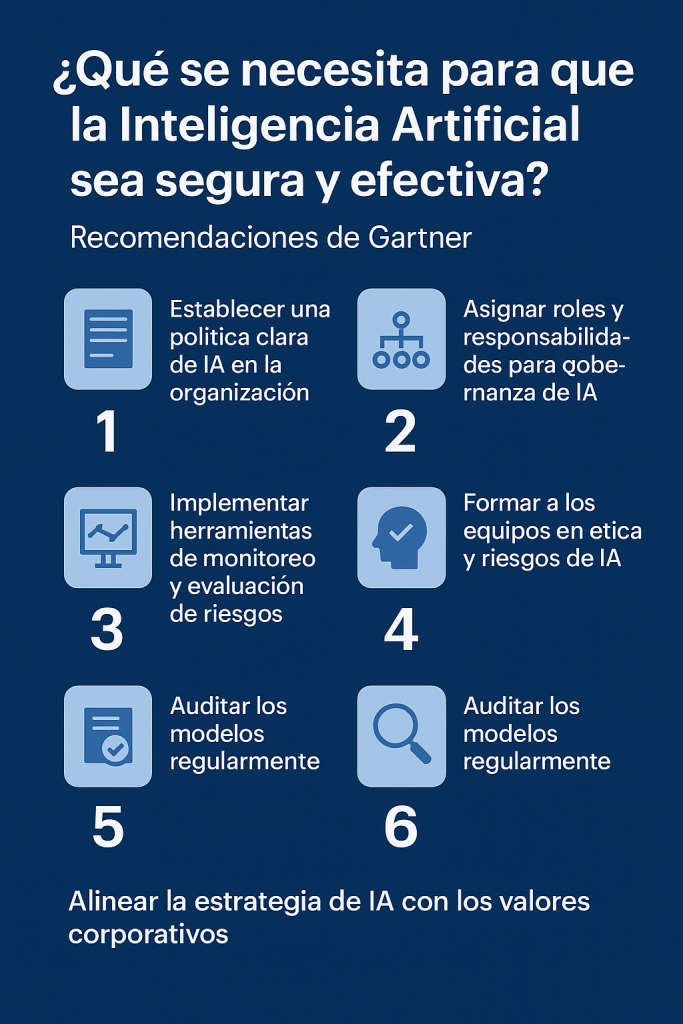

6. Recomendaciones clave de Gartner para una IA segura y efectiva

Gartner propone seis acciones esenciales:

- Establecer una política clara de IA en la organización.

- Asignar roles y responsabilidades para gobernanza de IA.

- Implementar herramientas de monitoreo y evaluación de riesgos.

- Formar a los equipos en ética y riesgos de IA.

- Auditar los modelos regularmente.

- Alinear la estrategia de IA con los valores corporativos.

Conclusión

La inteligencia artificial representa una de las mayores oportunidades —y también uno de los mayores riesgos— de nuestra era. Su éxito no dependerá únicamente de la potencia de sus modelos, sino de nuestra capacidad para implementarla con conciencia, ética y visión estratégica.

Una IA segura no es solo una opción deseable, sino una necesidad urgente para mantener la confianza de los usuarios, cumplir con la regulación y maximizar el impacto positivo de esta tecnología.

¿Tu organización ya tiene un programa de gobernanza de IA?

¿Has considerado los riesgos y desafíos éticos de tus implementaciones actuales?

Fuente: Gartner, ”¿Qué se necesita para que la inteligencia artificial sea segura y efectiva?”